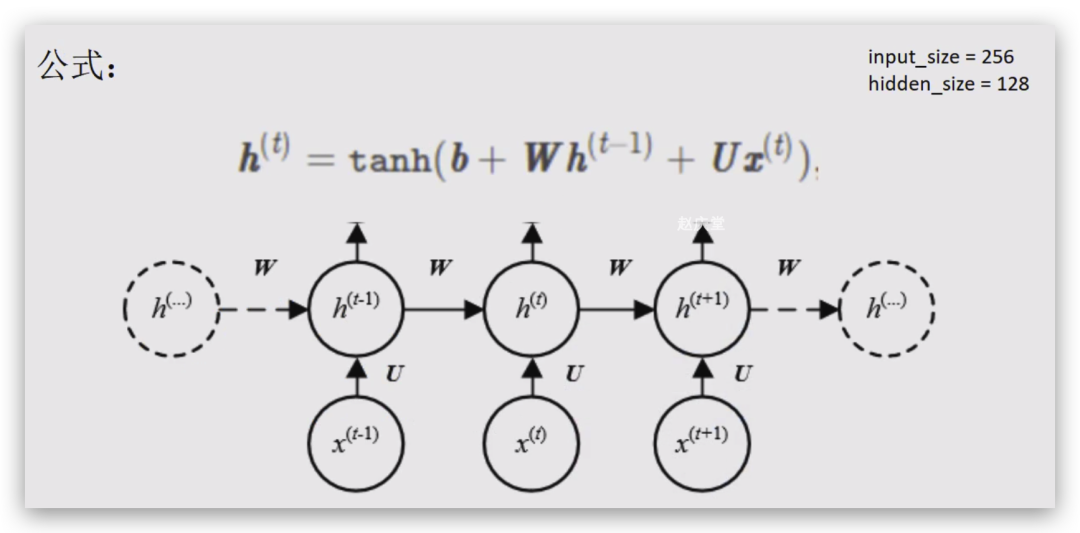

主要思想:将整个序列划分成多个时间步,将每个时间步的信息依次输入模型,同时将模型输出的结果传给下一个时间步 公式:

本质:两个线性层加和,再过一个tanh激活函数

import torch.nn as nn

output, h = nn.RNN(input_size, hidden_size, bias=False, batch_first=True)

输出

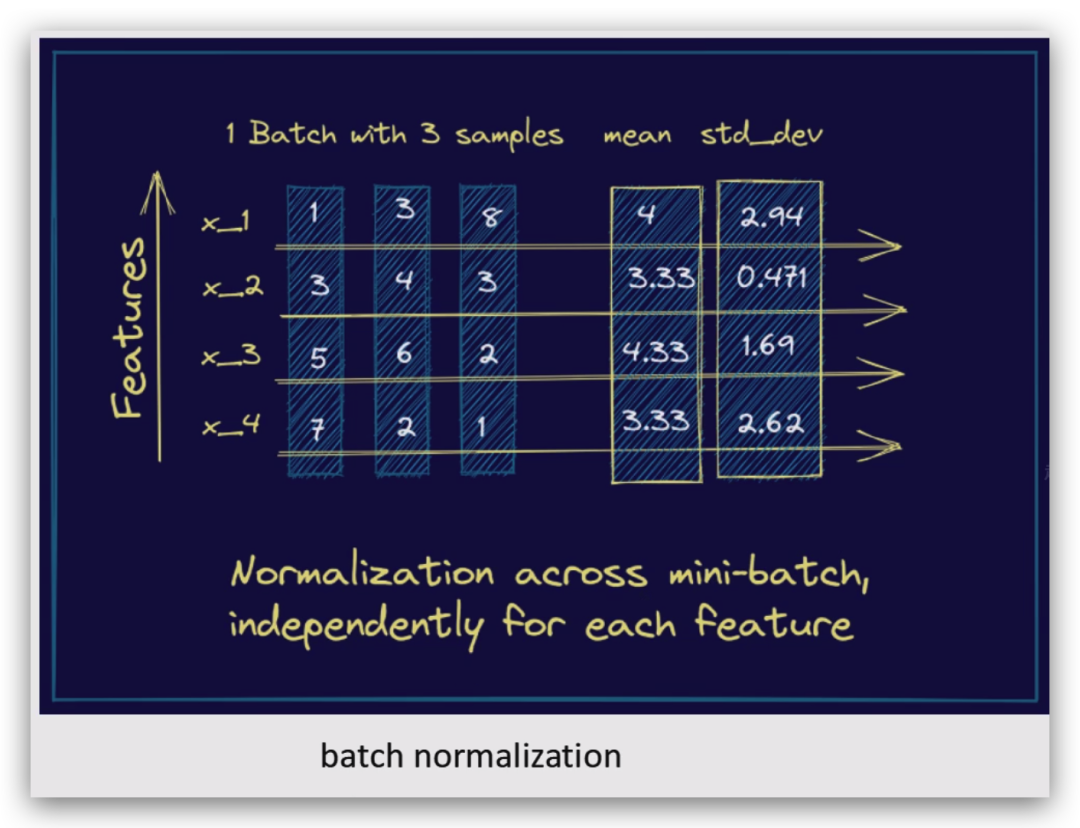

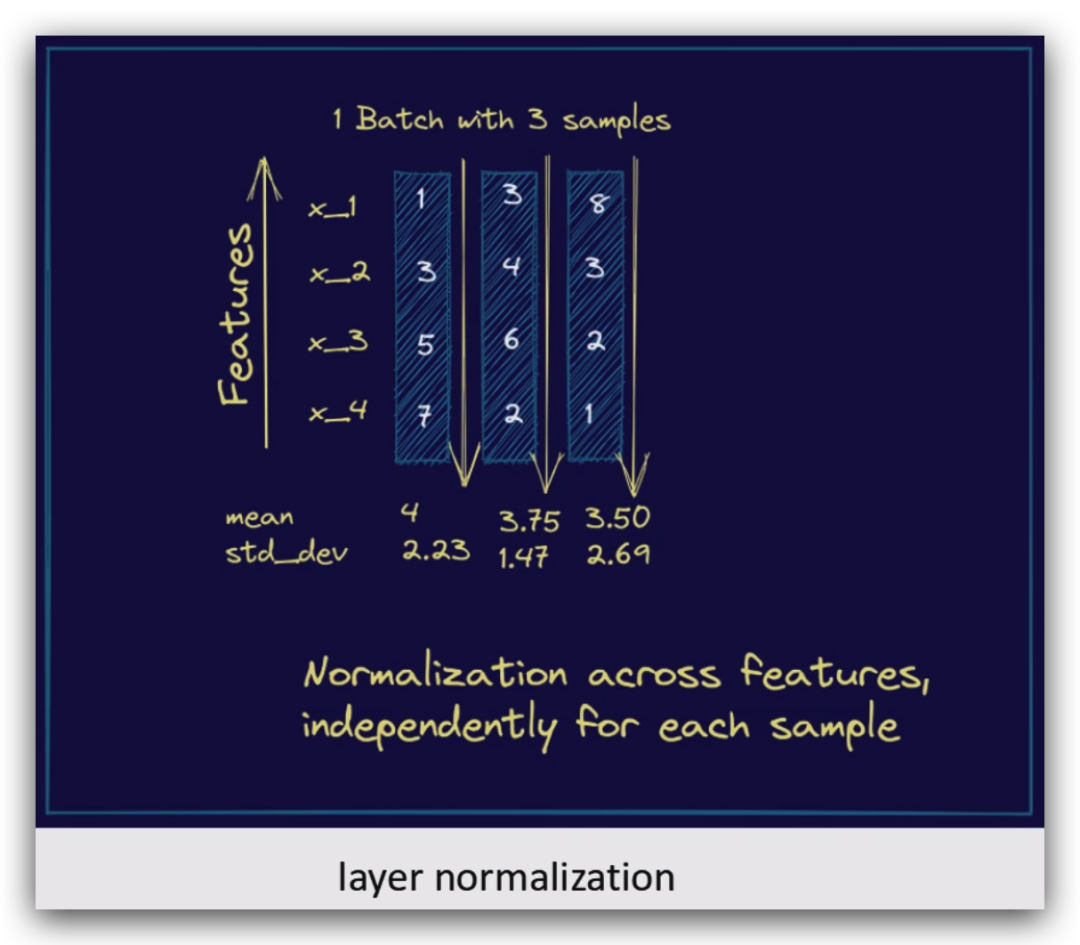

归一化的目的【来源:文心一言】:

不同样本的第1...n位置值求平均

一般应用于图像任务

同一个样本内的值求平均

一般应用在NLP任务

作用:减少过拟合 原理:按照指定概率,随机丢弃一些神经元(将其设置为0),其余元素乘以1/(1-p)进行放大

相当于只看到问题的一部分,就要求模型可以预测出正确值,对模型提出了更高的要求,减少过拟合(只要看到了某些样本就固定预测出某个结果),增加模型的泛化性