本篇文档包含1个案例,案例描述了将第三方模型部署为在线服务的使用链路,适用于仅需使用 TI-ONE 进行模型推理的用户。

案例:将第三方模型导入平台,并部署为在线服务

本案例以平台预置模型包中 PyTorch 图像分类模型为例,讲解如何将第三方模型部署为在线服务,部署完成后,用户可通过在线测试功能调用服务,识别输入图片的图像种类。

准备内容

1. 模型包

1.1 登录 TI-ONE 控制台,在左侧导航栏中选择模型管理 > 模型仓库,进入模型列表页面;

1.2 下载对应的模型文件和推理文件 demo,可 单击此处 下载。

1.3 这里以pytorch > detect模型为例演示后续步骤。

2. 测试数据已为您准备了如下测试数据,可以在服务发布后直接用于调用测试。

https://tione-prod-open-1256580188.cos.ap-guangzhou.myqcloud.com/ti-cloud/ti-ems/tiacc-demo-models/ts-yolov5/dining_table.jpg?步骤1:导入模型仓库

1. 进入 TI-ONE 控制台,在左侧导航栏中选择 模型管理 > 模型仓库 ,进入模型列表页面。

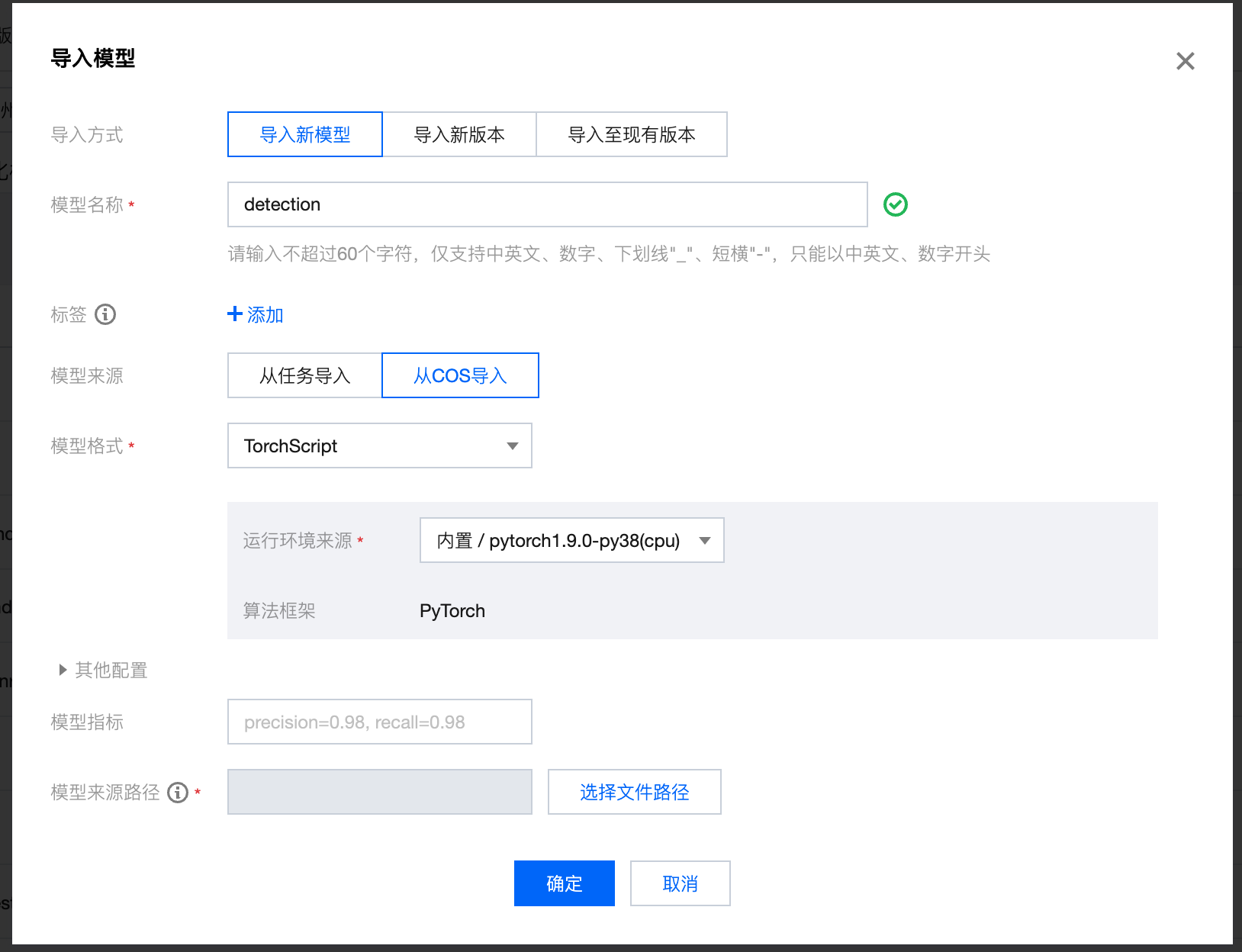

2. 单击 导入模型 ,在模型导入页面参考如下参数填写。

导入方式:选择 导入新模型

模型名称:自定义模型名称,例如命名为 detection

标签:按需添加,可不配置

模型来源:选择从 COS 导入(需要提前将模型文件上传到 COS 中)

模型格式:选择 TorchScript

运行环境来源:建议使用内置的运行环境,例如 pytorch1.9.0-py38(cpu)

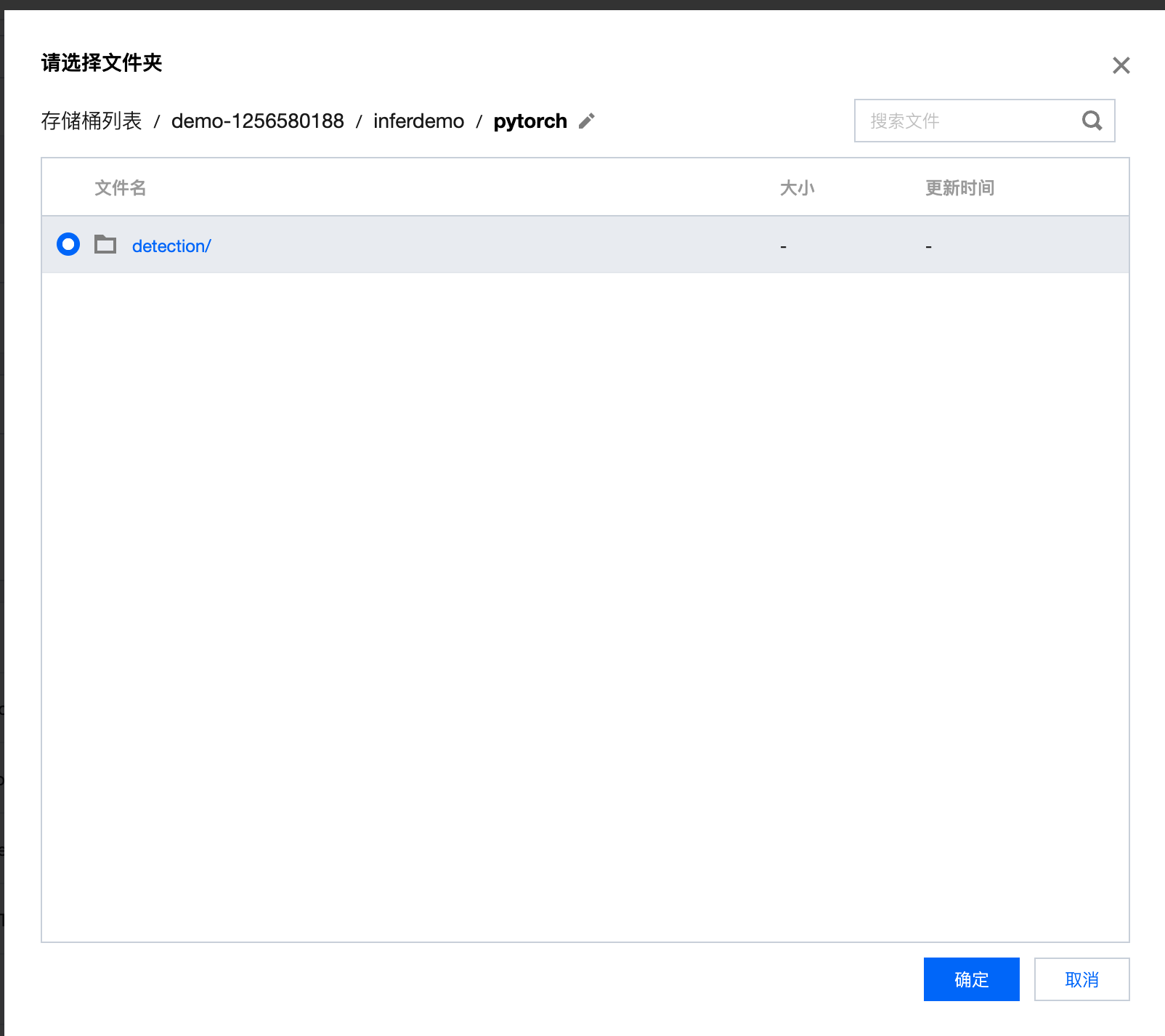

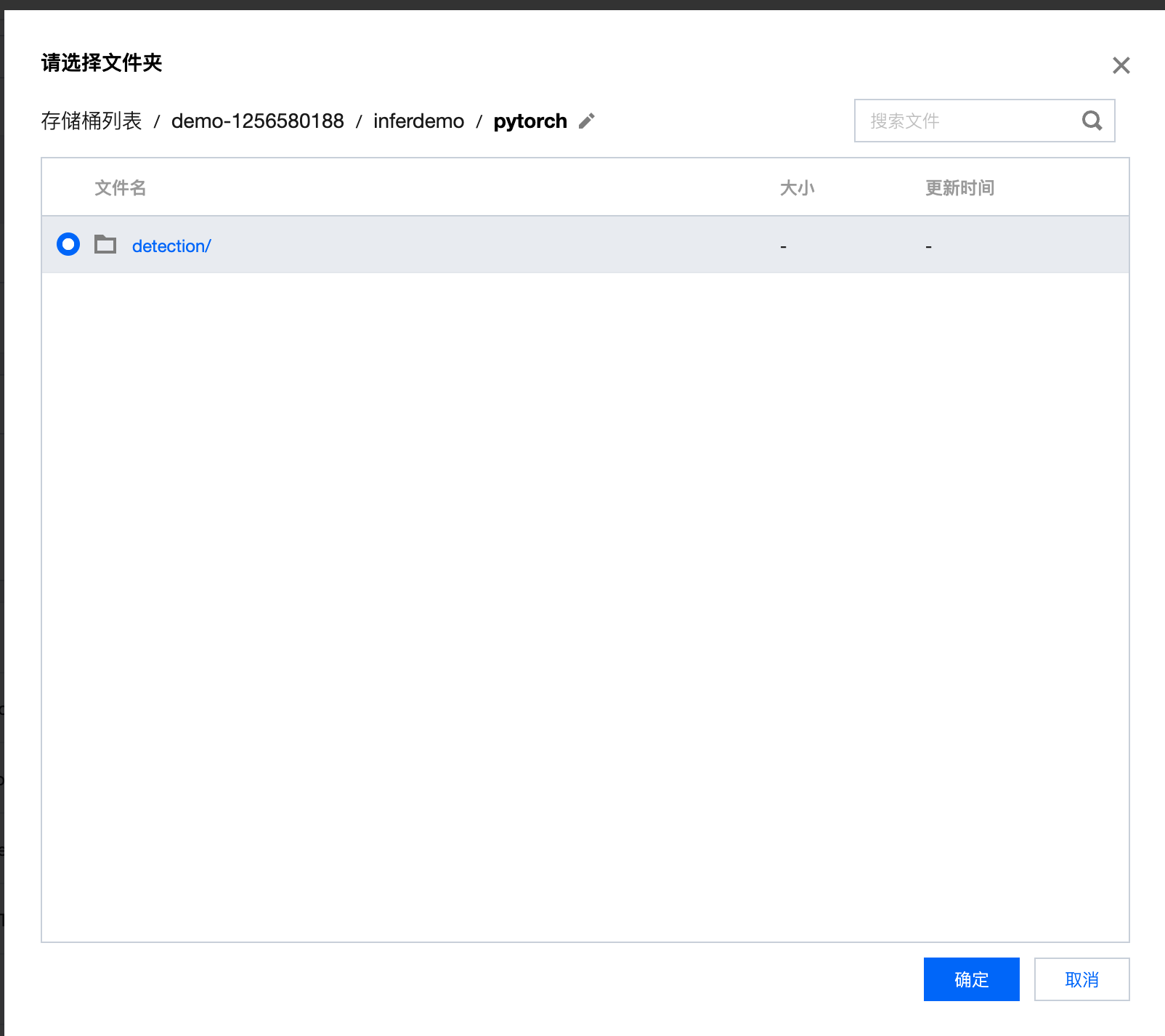

模型文件:单击选择文件,在弹出的 COS 对话框中,选择需要使用的存储桶,单击左下方上传文件夹,将模型包中的模型文件夹上传,上传完成后选中文件夹路径

?

?

3. 单击确定 ,完成模型文件的导入。

步骤2:启动在线服务

1. 进入 TI-ONE 控制台,在左侧导航栏中选择 模型管理 > 模型仓库 ,选择步骤1创建好的模型。

2. 单击 操作-发布在线服务 ,在启动服务页面参考如下参数,填写服务基础信息

服务名称:自定义服务名称,例如命名为 classify

服务描述:按需填写服务描述信息,可不配置

计费模式:若您尚未使用过资源组管理模块,建议选择 按量付费 模式

3. 服务实例信息,可参考如下参数填写:

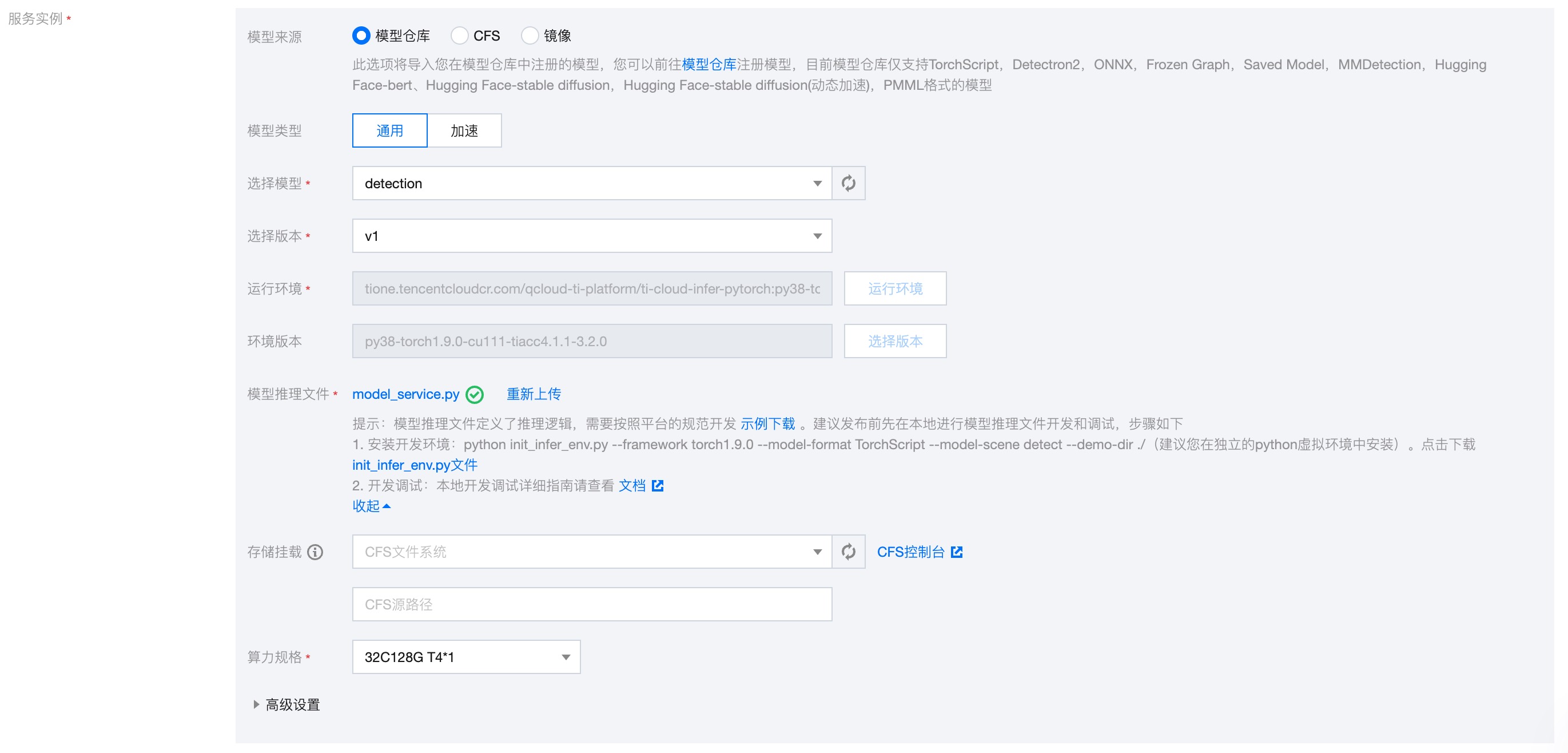

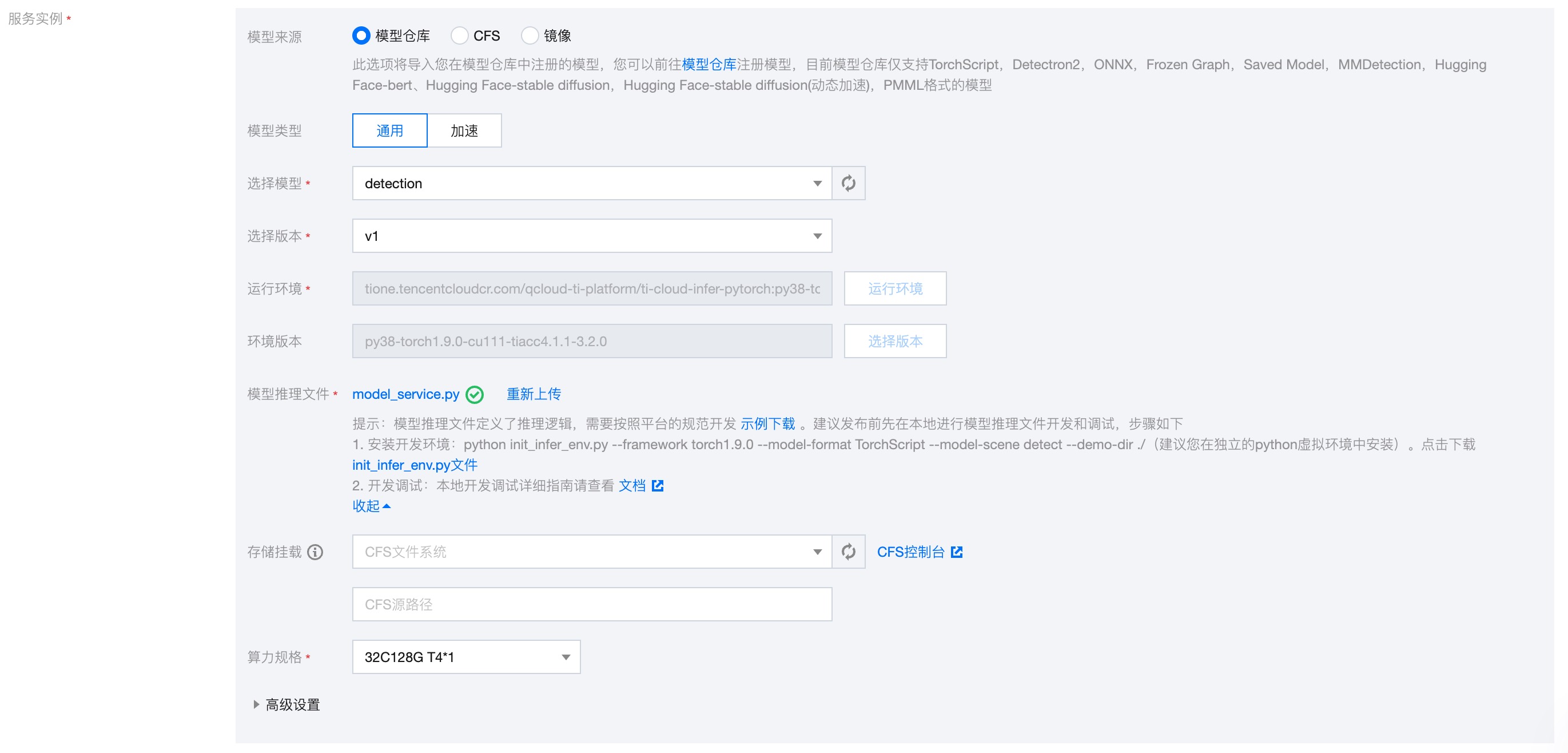

模型来源:默认选择 从模型仓库选择模型

选择模型:默认选择上一步骤中导入的模型文件 detection

选择版本:默认选择 v1

模型推理文件:将模型推理文件 model_service.py 上传(下载的模型包中已经提供了 model_service.py,会自动带出,用户也可以自行上传)

存储挂载:默认不填写

算力规格:按需选择,例如 32C128G T4 * 1

高级配置/启动命令:默认不填写

高级配置/环境变量:默认不填写

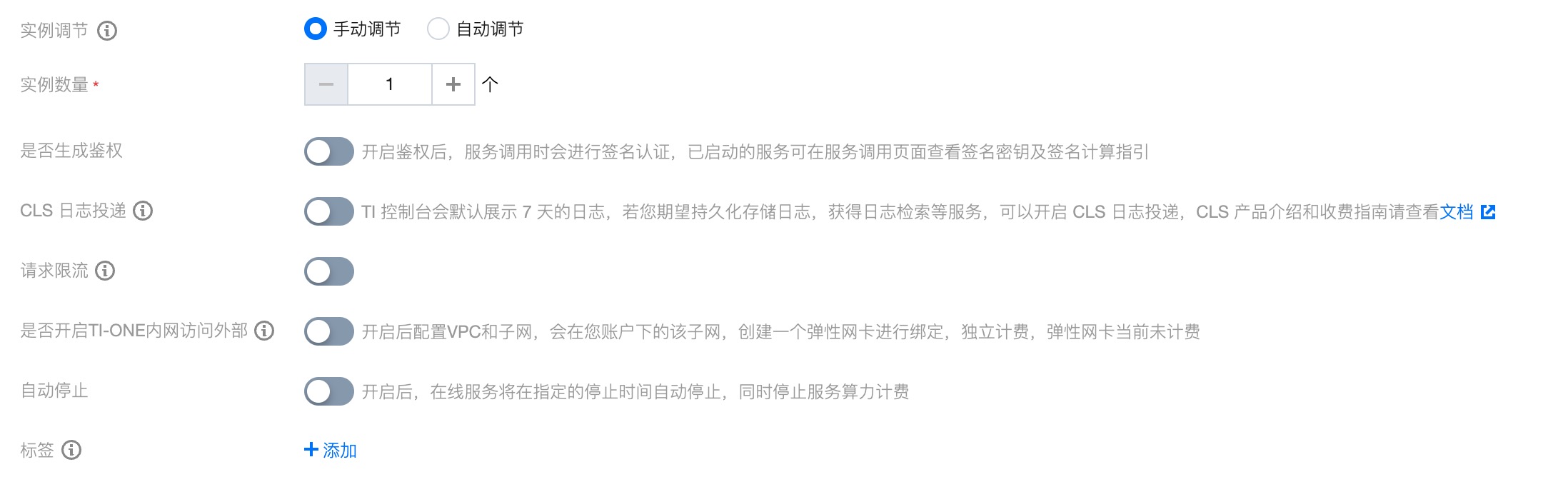

4. 参考如下信息完成服务高级配置

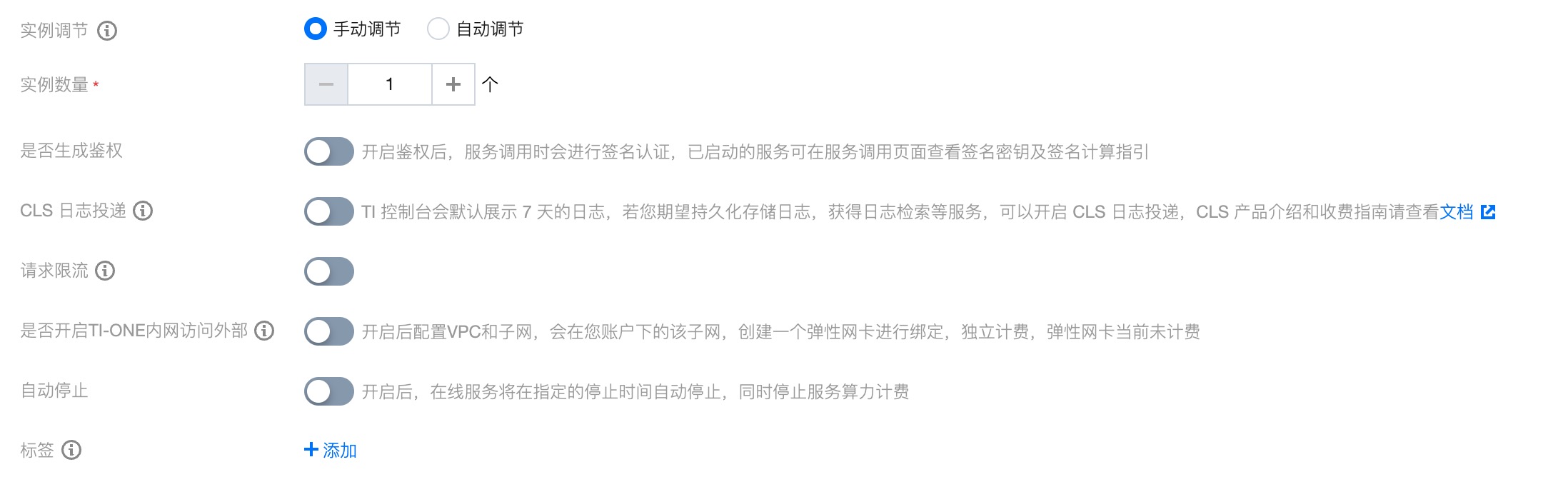

实例调节:按需选择,可使用默认值 手动调节

实例数量:按需配置,可使用默认值1

是否生成鉴权:按需开启,可使用默认值关闭

CLS 日志投递:按需开启,可使用默认值关闭

请求限流:按需开启,可使用默认值关闭

是否开启 TI-ONE 内网访问外部:按需开启,可使用默认值关闭

自动停止:按需开启,可使用默认值关闭

标签:按需添加,可不配置

5. 单击启动服务,若选择按量计费模式,会出现费用冻结确认。按量计费模式需要预先冻结两小时费用,若您账户内余额充足,单击确定即可完成服务创建。此时在服务列表中,新创建的服务会处于创建中状态,服务部署过程中将为您创建网关并调度计算资源,需要等待一段时间,待服务成功完成部署时,服务状态将变为运行中。

步骤3:服务调用测试

1. 确认上一步中发布的服务已完成部署,处于 运行中 的状态。

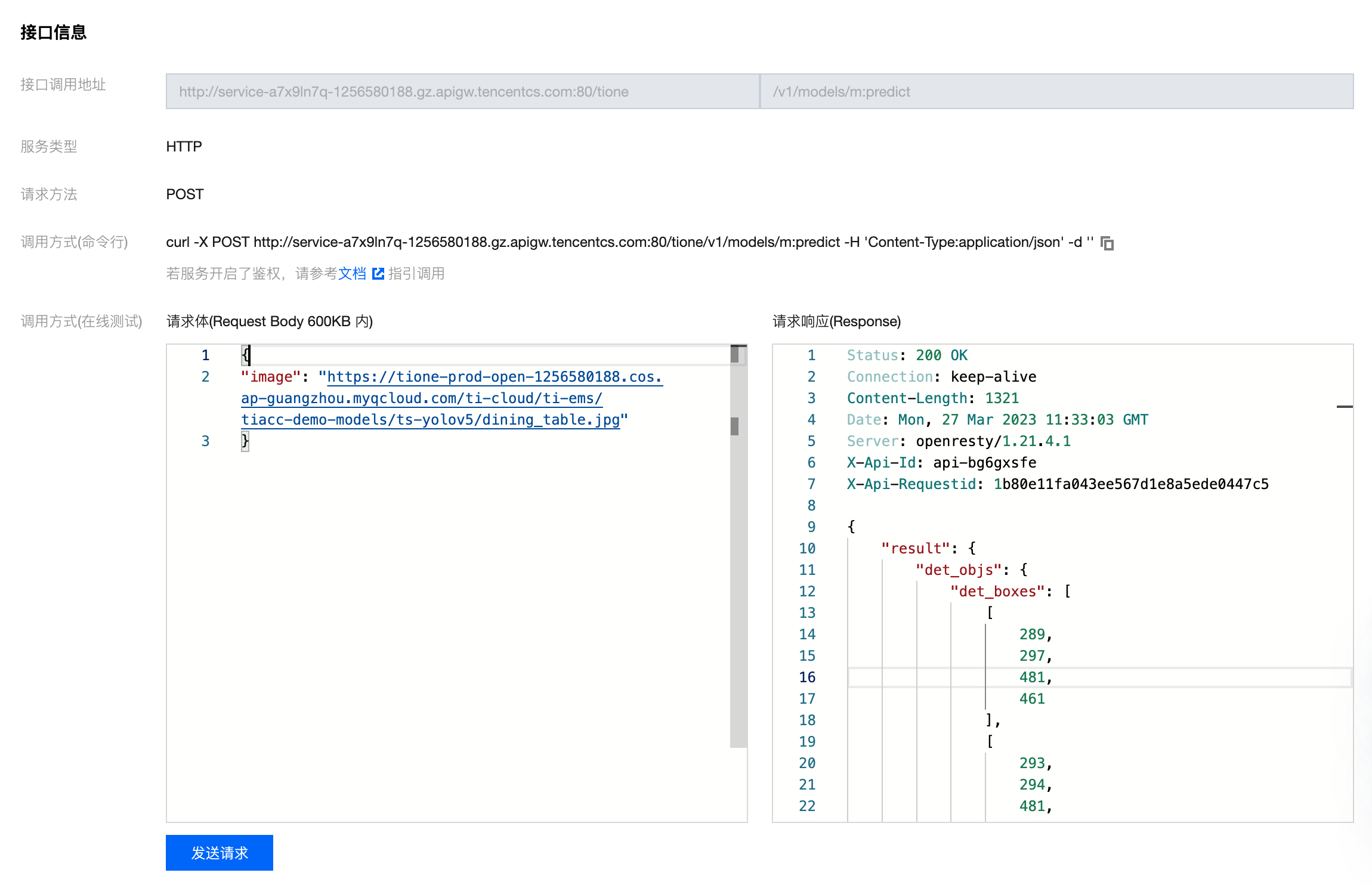

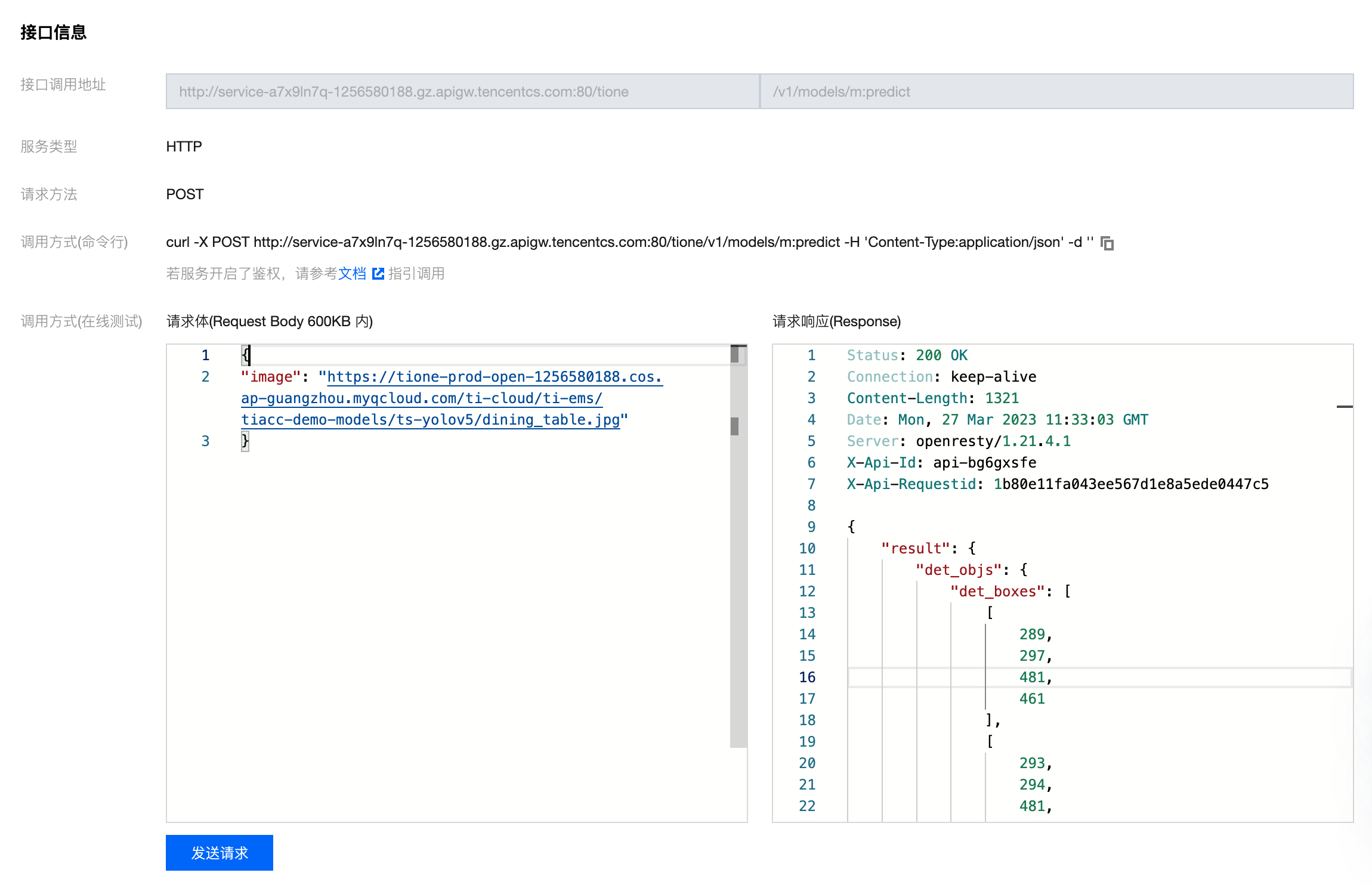

2. 单击 调用 操作,进入服务调用页面。

3. 在接口信息页面,可直接进行在线测试,本模型的示例请求如下:

在请求体中录入图片路径

{"image": "https://tione-prod-open-1256580188.cos.ap-guangzhou.myqcloud.com/ti-cloud/ti-ems/tiacc-demo-models/ts-yolov5/dining_table.jpg"}此时模型会实时返回测试结果。