操作场景

本文将演示如何使用 GPU 云服务器部署优化过的 AI 绘画模型 web UI 界面,结合 TACO Infer 的加速能力助力您获得 30% 以上的端到端性能提升。

操作步骤

购买 GPU 云服务器

实例: 选择 计算型 PNV4。

系统盘:配置容量不小于 200GB 的云硬盘。

镜像:建议选择公共镜像。

操作系统使用 CentOS 7.9。

选择公共镜像后请勾选后台自动安装GPU驱动,实例将在系统启动后预装对应版本驱动。如下图所示:

?

注意:

当前优化版本仅支持 A10 GPU 机型,请检查您的实例配置。

安装docker和NVIDIA docker

1. 参见 使用标准登录方式登录 Linux 实例,登录实例。

2. 执行以下命令,安装 docker。

curl -s -L http://mirrors.tencent.com/install/GPU/taco/get-docker.sh | sudo bash

说明:

3. 执行以下命令,安装 nvidia-docker2。

curl -s -L http://mirrors.tencent.com/install/GPU/taco/get-nvidia-docker2.sh | sudo bash

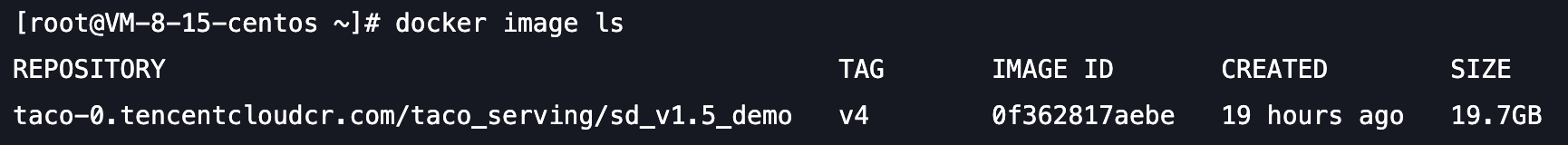

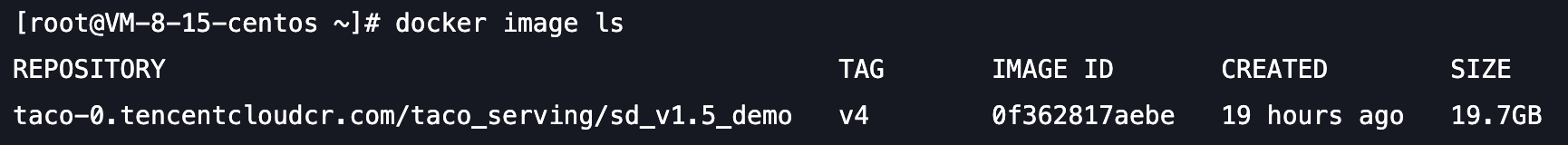

下载 docker 镜像

执行以下命令,下载 docker 镜像,演示需要的所有数据和运行环境全部打包在docker镜像中。

docker pull taco-0.tencentcloudcr.com/taco_serving/sd_v1.5_demo:v4

模型下载完成,查看下载的 docker 镜像:

?

下载优化后的模型

执行以下命令,创建 optimized_model 目录,下载模型后回到上层目录:

mkdir optimized_model && cd optimized_modelwget https://taco-1251783334.cos.ap-shanghai.myqcloud.com/demo/sd/unet/optimized_recursive_script_module.ptcd ..

启动 docker 镜像

如果您当前所处路径是/root/,执行以下命令,启动 docker 镜像。或者 -v 参数修改为 optimized_model 所在目录。

docker run -it --rm --gpus=all --network=host -v /root/:/data taco-0.tencentcloudcr.com/taco_serving/sd_v1.5_demo:v4 --listen

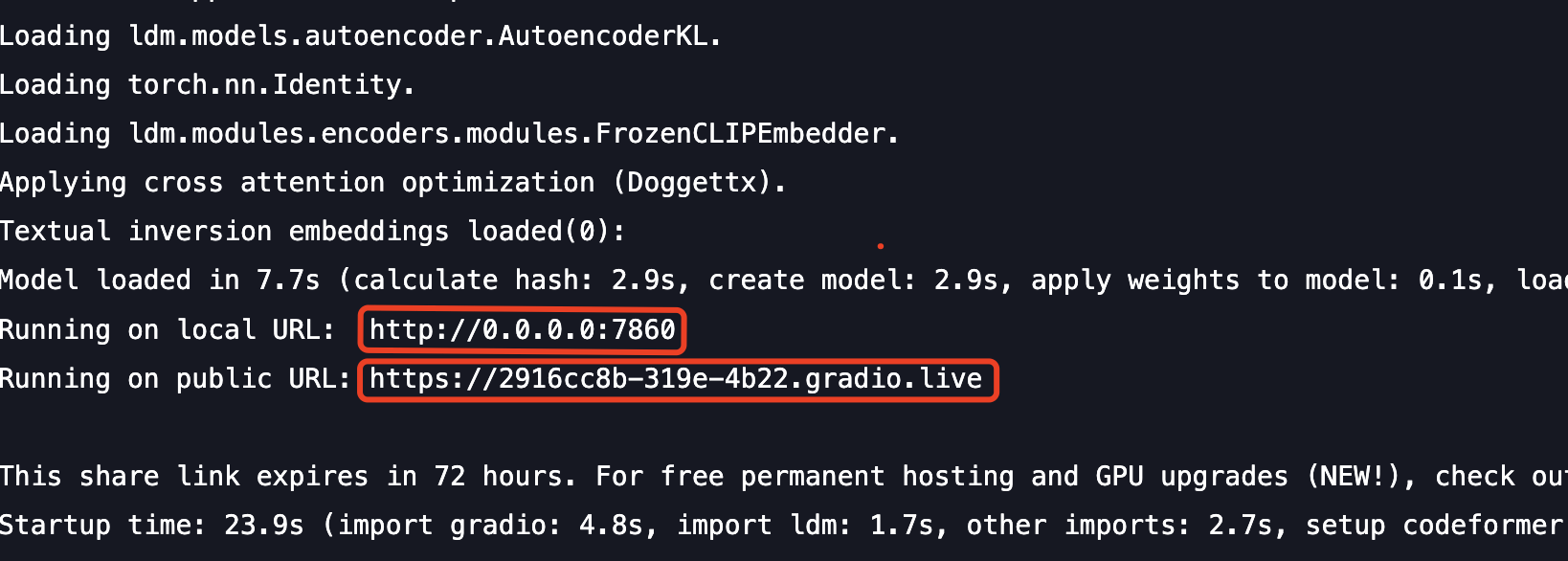

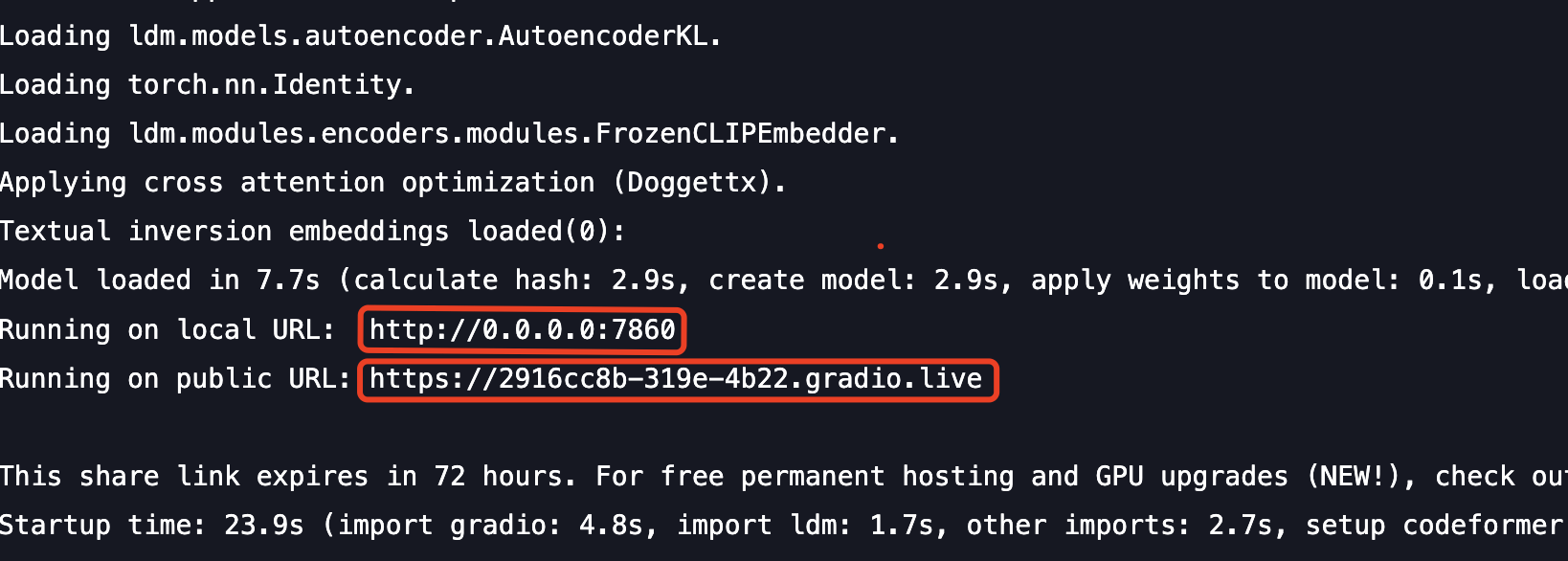

启动 Stable Diffusion web UI

复制 public URL 到浏览器,即可打开 webUI界面。或者您可以选择将 local URL 的 0.0.0.0 替换成公网 IP,在浏览器打开页面。

?

TACO Infer 优化过的模型单张图片处理时间约 1 秒,开源模型单张图片处理时间约 2 秒。

?

经过 TACO infer 优化,模型的前向推理能力提升 4 倍多,端到端性能提升 50%,由原来的约 2 秒缩短到 1 秒。