已经是2024年了,但貌似AI大模型的热度依旧未减,各种如ChatGPT般的生成式的AI大模型层出不穷,由此而来的还有各种网站、小程序都可以支持AI大模型对话,那么你有没有想过能拥有一个自己的AI大模型?

今天我就来给大家分享一下如何本地跑一个AI大模型,通过简单的安装后即使不需要联网也能使用。其本质就是把训练好的AI模型下载到本地,然后通过特定的客户端调用,从而达到在本地使用AI大模型的效果,话不多说,开始分享。

当然需要先介绍下今天的主角ollama, 它是一个专门用来运行大语言模型的框架,也可以叫做工具,它在官网的介绍也只有一句话"Get up and running with largelanguage models."(开始使用大型语言模型)。

官网地址:https://ollama.com/

Github开源仓库:https://github.com/ollama/ollama

本地运行大模型基本上有4步:

下面我们开始:

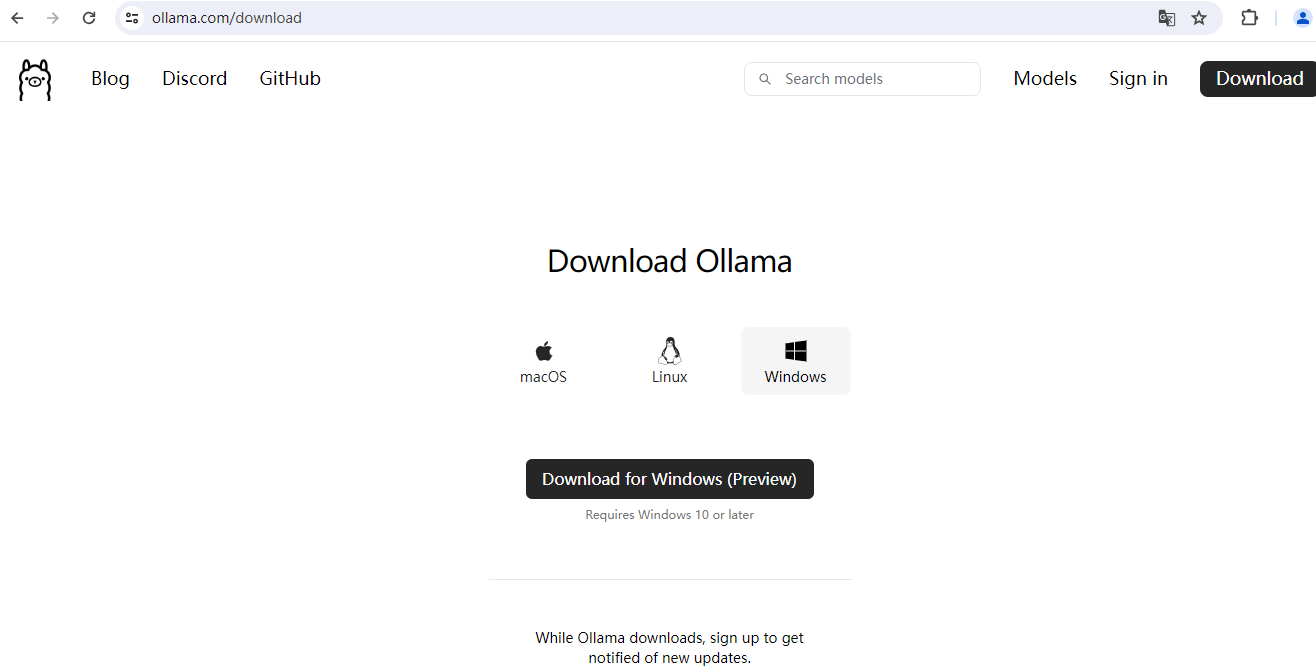

(1)下载并安装ollama客户端

下载页面地址:

安装目前所使用的操作系统选择性下载,然后傻瓜式安装就可以了:

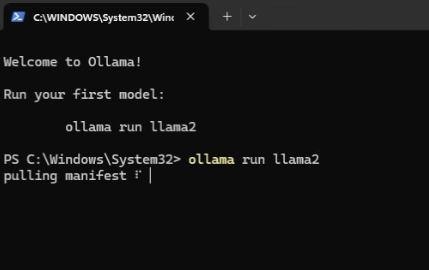

(2)安装适用的大模型

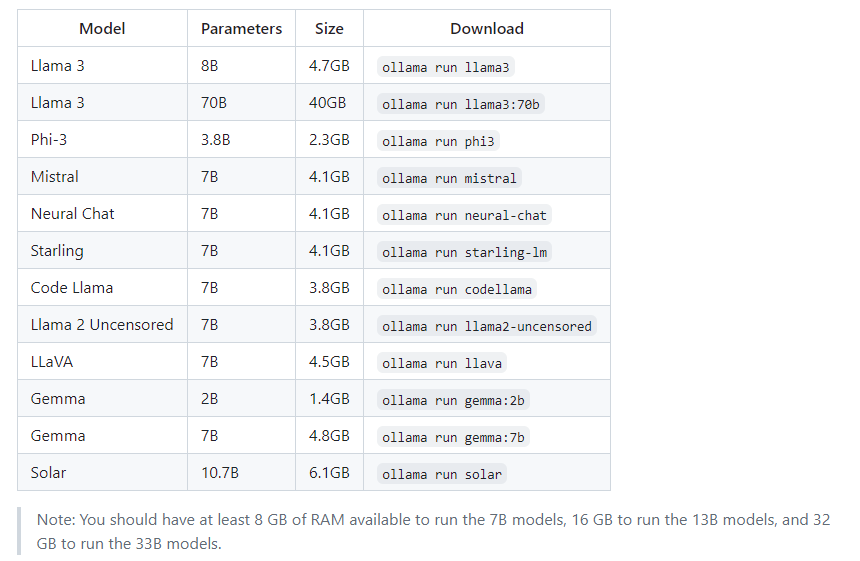

我们首先按照提示安装llama2模型,当然Github仓库的README里也有对其他模型的支持,参数数量和模型的大小都有简单的说明。

下面有一个说明,翻译过来就是:

您应该至少有8GB的内存才能运行7B的大模型,16GB内存可用于运行13B的大模型,32GB内存可用于执行33B的大模型。

(3)运行大模型

我们先通过终端问它一个问题:Do you know Go language?

然后它就会以流式的输出形式来回答你,所谓流式,其实就是慢慢悠悠,一个字一个字的回答你,和人说话一样一句一句的讲。

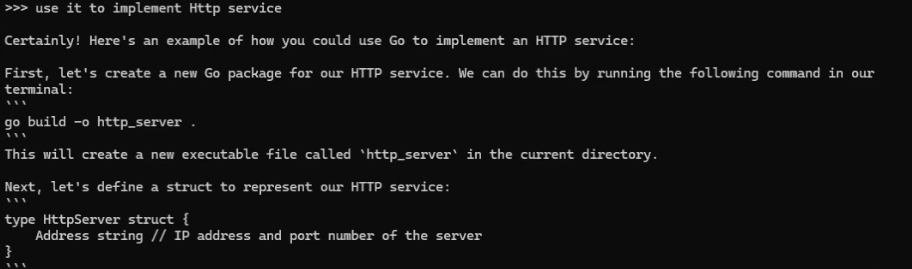

然后我们在试下它的上下文理解能力,和它说:use it to implement Http service。

它直接使用Go语言实现了一个HTTP服务,看来它是有天然的上下文理解能力的。

(4)安装Web客户端

ollama已经帮我们收集了社区中可以当做客户端使用的工具,这里就不做演示了,大家可以安装各个仓库对应的说明文档进行安装和使用!

到这里就结束了,另外给大家一个小提示,本地跑大模型是很消耗电脑CPU和显卡的事情,如果电脑配置比较差的话可能体验会不是很好,并且长时间运行也可能对电脑有一定的影响,大家适度尝试即可~

原创声明:本文系作者授权腾讯云开发者社区发表,未经许可,不得转载。

如有侵权,请联系 cloudcommunity@tencent.com 删除。

原创声明:本文系作者授权腾讯云开发者社区发表,未经许可,不得转载。

如有侵权,请联系 cloudcommunity@tencent.com 删除。